BTC/HKD-3.86%

BTC/HKD-3.86% ETH/HKD-5.4%

ETH/HKD-5.4% LTC/HKD-3.64%

LTC/HKD-3.64% ADA/HKD-7.02%

ADA/HKD-7.02% SOL/HKD-10.69%

SOL/HKD-10.69% XRP/HKD-6.57%

XRP/HKD-6.57%你知道 《太空歌劇院》 嗎?

它是一幅 AI 作的畫,并拿到了藝術比賽的一等獎。在 2022 年,AI 作畫已經變得如此簡單,你只要會打字就行。在一片高斯噪聲中逐漸顯露出精彩絕倫的顏色和圖案,AI 是怎么畫畫的?為什么能畫得這么好?會不會取代人類設計師?

更令人費解的在于,AI 有沒有自己的邏輯思辨能力?

其實,我們還處在人工智能的早期,AI 對真正的邏輯和某個垂直領域的理解還不深,但不斷強化它的邏輯思維能力一定會是接下來研發的重點。

書接上回,這次真格投資副總裁林惠文將帶領我們,從上次 ChatGPT 的 AI 文字跳到 AI 圖片(ChatGPT:又一個AI突破的時刻|真格投資人專欄),繼續探索 AI 世界。從 AIGC 圖片背后的模型,到模型之間的關系以及發展歷程。 除此之外,我們還準備了對 AI 領域相關問題的解惑和一些好用的工具推薦,請一定不要錯過~

非常榮幸今天能跟大家分享一些 AIGC 圖片相關的梳理,在漫漫的熊市之中,近期我們看到了很多驚人的生成效果。

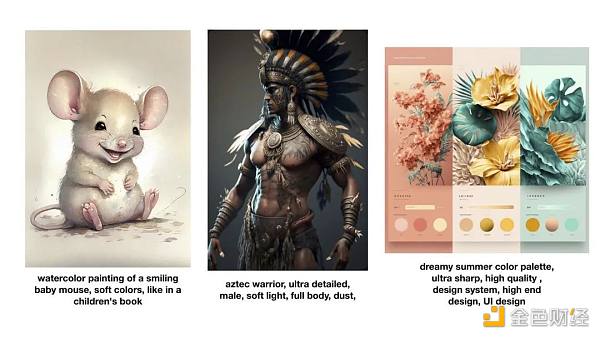

首先我們來看一下 AI 生成的圖片。

這是最近非常火的 AI 生成圖片平臺 Midjourney (強烈推薦大家試試看)產生的一些圖片效果,可以看到非常真實,也有很強的創意效果。它是如何做到的?

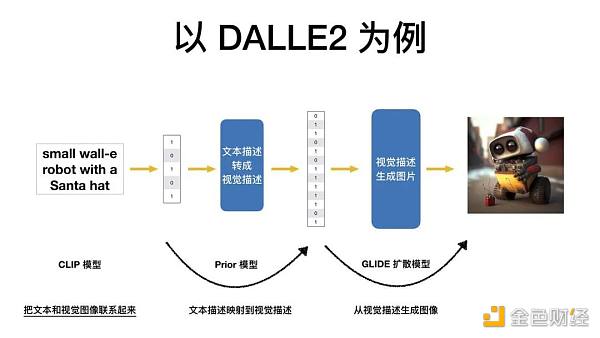

通俗易懂地來講有三個步驟。首先,把人類的文字轉換成計算機能夠理解的表達,然后把計算機能理解的文本表達轉換成計算機能理解的視覺描述,再接下來,把計算機能理解的視覺描述生成人類能夠看懂的圖片。

蘋果公司預計將于周二從App Store中刪除Damus:金色財經報道,蘋果公司預計將于周二從App Store中刪除Damus,因為據報道該應用程序違反了該公司的應用內購買準則。

Damus創始人William Casarin表示,蘋果希望從所有筆記或內容部分中刪除zap按鈕,蘋果認為這種配置等同于銷售數字內容,盡管用戶個人資料上有zap按鈕也不行。我與Apple通了電話,他們告訴我,他們不希望使用zap進行銷售,我認為我們可以做的妥協之一是我們實際上會刪除所有筆記切換功能。Casarin稱他修改了Damus界面,以便zap按鈕仍然會出現在筆記上,但zap本身不會與任何筆記相關聯,并且只會在個人資料級別發送和處理。Casarin表示,蘋果公司對他的妥協并不滿意。

蘋果證實已與Casarin接洽,并向他清楚地解釋了如何解決該問題。[2023/6/27 22:02:01]

以 DALLE2 為例,它訓練了 3 個模型來做這件事情。接下來,我會分別講述。

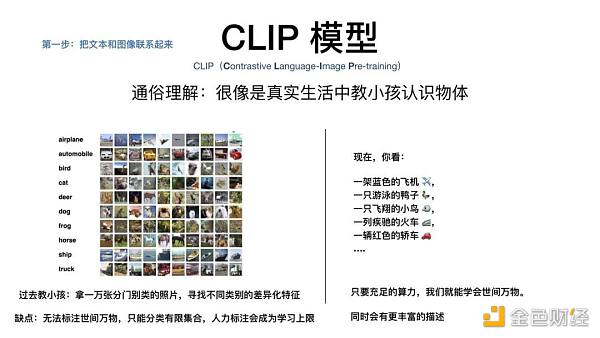

第一個模型是 CLIP 模型,負責將文本和視覺圖像聯系起來。

過去的很多算法就像是拿 1 萬張人類已經標注了類別的照片,讓計算機去尋找不同類別照片的差異化特征。最大的缺點是,它無法標注世間萬物,只能分類有限的集合,同時人力標注會成為學習的上限。

CLIP 模型帶來的新思路是什么?它很像是真實生活中教小朋友認識物體。看到一個東西就直接告訴小朋友,這是一只游泳的鴨子,而不是一次性拿 20 張鴨子的圖片告訴他,這是鴨子,你記住它的所有特征。CLIP 模型的算法實現了這樣一個特點,只要我們有充足的算力,就能學會世間的萬物。

CLIP 模型的數據集從哪來?它來自于互聯網上圖文的匹配對,總共收集了 4 億張的圖文匹配對,再經過一個圖文編碼器,把人類能看懂的文字和圖片轉換成計算機能懂的數據結構。

某巨鯨3月8日至今已累計從Amber處買入 360 萬枚 DYDX 和 1050 萬枚 BLUR:金色財經報道,據推特用戶余燼監測,某巨鯨再度從 Amber 處接收了 50 萬枚 DYDX 和 100 萬枚 BLUR,從 3 月 8 日至今已累計買入 360 萬枚 DYDX(均價 2.57 美元)、1050 萬枚 BLUR(均價 0.66 美元),目前 DYDX 浮虧 173 萬美元,BLUR 浮虧 190 萬美元。[2023/5/14 15:01:30]

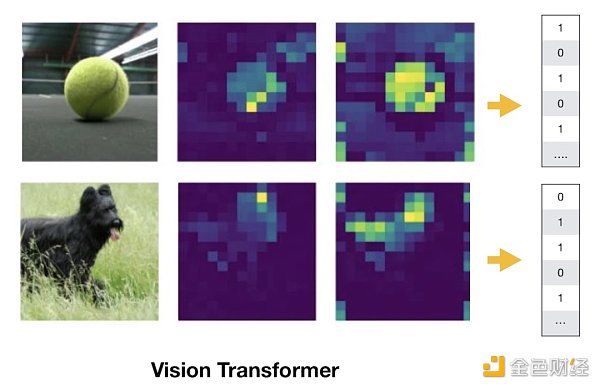

CLIP 模型用到了兩個編碼器,視覺編碼器叫 Vision Transformer,文字編碼器叫 Transformer。下圖是 Vision Transformer 編碼器產生的效果圖,可以看到兩張圖片里背景部分的顏色被大幅弱化,強調了網球和黑狗的輪廓。這就是優秀的編碼器能實現的效果:用人類的視角找重點,進行數據降維。

CLIP 模型做的事是什么?把來自互聯網的 4 億張圖片和 4 億條文本進行編碼,并兩兩配對,形成一個 4 億 * 4 億的矩陣。

CLIP 模型的訓練目標是什么?通過各種各樣的復雜計算,讓原本匹配的圖片和文本產生正相關。將蘋果的照片和蘋果的文字進行匹配,而不是摩托車或其他。

CLIP 模型實現的功能是什么?給定任何一個文本,能返回相關性最高的圖片;給定任何一張圖片,能返回相關性最高的文本描述。實現海量的圖像和文字特征的 mapping。

有了 mapping 以后,接下來重要的是如何從視覺的描述中產生圖像,這是 GLIDE 擴散模型。

5500萬枚USDC從Arbitrum Gateway合約地址轉至未知地址:金色財經報道,Whale Alert監測數據顯示,北京時間今日15:33:23,5500萬枚USDC從標記為“Arbitrum One: L1 Arb - Custom Gateway”的合約地址轉至未知地址。[2022/12/10 21:35:44]

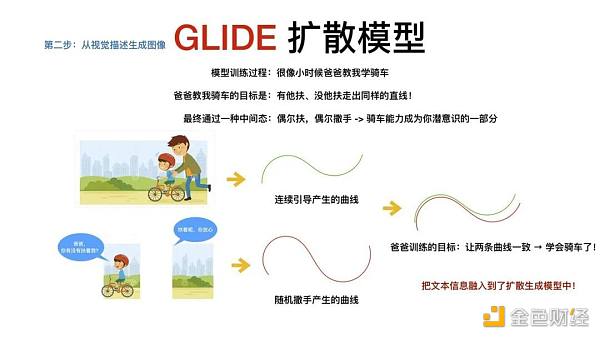

它就像是教小朋友學畫畫,先給小朋友看一張簡筆畫,逐漸把它擦掉,讓小朋友在大人的引導之下,試著從白紙開始恢復這張簡筆畫。

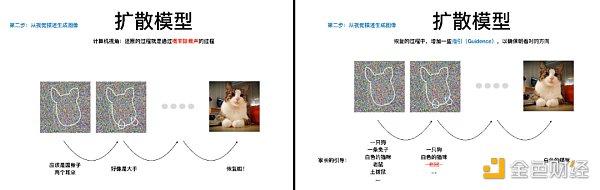

從計算機的視角來看,擦除的過程就是給圖片不斷增加噪聲的過程,這種噪聲是一種正態分布的噪聲,叫高斯噪聲,直到最后變成一張純噪聲的圖片。恢復的過程就是通過概率除去噪聲的過程,這中間往往會加一些指引,叫 Guidance,以確保恢復的過程朝著對的方向。

左圖為增加噪聲的過程,右圖為除去噪聲的過程

GLIDE 擴散模型帶來最大的創新就是在訓練的過程中融入了文本的信息。在 CLIP 模型的基礎上,在恢復的過程中嵌入文本的信息,這就導致了難度的快速疊加,因為它既要學會恢復的算法,又需要學會識別的算法。然而,在恢復的過程中,它并沒有把知識完全融入其中,如何才能把知識徹底地融入到圖像生成里?

GLIDE 模型的抽象理解,就像是爸爸教小朋友騎車,目標是希望在有爸爸扶和沒有爸爸扶的時候,小朋友都能騎出同樣的曲線。這往往通過一種中間形態來實現,從一直扶到偶爾扶,偶爾撒手,最終的訓練目標就是不斷在這種狀態里達成。

GLIDE 擴散模型的目標也是如此,在它的原理中,爸爸扶著小朋友就是分類器,能幫助分類或目標識別,撒手就意味著無分類器指引,有時會將一些文本的信息替換成空的字符串,隨機替換掉一些信息。當有分類器產生的曲線和沒有分類器指引產生的曲線一致時,整個文本的信息就融入到了生成過程中。

Celsius從Aave和Compound收回1.72億美元的抵押品:金色財經消息,加密借貸平臺Celsius Network向Aave和Compound償還了9500萬美元債務,此舉釋放了鎖定在平臺中的1.72億美元抵押品。

Nansen數據顯示,與Celsius相關的錢包在各種交易中轉移了3500萬美元的DAI和4000萬美元的USDC穩定幣,另外根據Etherscan的數據,該錢包還在周日晚些時候向Aave協議支付了另外2000萬美元的USDC。

根據Zapper的儀表板顯示,在這些舉措之后,該公司仍欠Aave和Compound 1.4億美元,比上周五的2.35億美元有所減少。(Coindesk)[2022/7/12 2:06:23]

有了 GLIDE 擴散模型以后,還可以制定不同的引導目標,因此會產生不同的效果,如果你想生成與某張圖片一樣效果的圖片,你可以輸入這張圖片,接著就會得到一張類似風格的圖片。這就像是一個小朋友的爸爸告訴他,自行車的前輪其實是個裝飾品,他最終在不斷的強調之下,就會學會這樣騎車的方式。

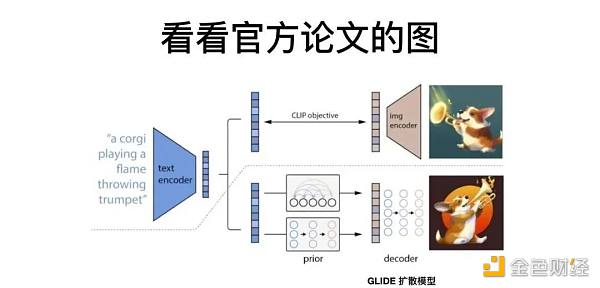

當 CLIP 模型將文本和視覺相連,GLIDE 模型通過概率恢復一張隨機的模糊照片,并把文本信息融入其中,我們還缺少了這兩者之間的聯結,如何把文本描述映射到視覺描述中,這就是 PRIOR 模型的核心。

有了 CLIP 模型,雖然能夠實現文本和視覺之間相關性的描述,但還缺少一個轉換器,那就是面對一個新的描述,如何產生一張新的圖片。就像你教會了小朋友畫帽子,也教會了畫兔子,現在如何讓他畫一張戴帽子的兔子。PRIOR 模型其實是在 CLIP 模型之后產生一個新的效果,在 CLIP 模型中用到的文本和圖片編碼器,給編碼后的東西再增加一個特征,這就使得文本和圖片的信息都融合在同個維度,便于我們去操作。

CLIP 模型理解了圖片與文字的關系,PRIOR 模型就是在理解圖片與文字的關系之上,從文字中產生一個腦海中的構圖,GLIDE 擴散模型就是要把腦海中的構圖畫出來,畫出人類能懂的視覺圖片。

TrustToken從a16z及Blocktower等融資1250萬美元:金色財經報道,去中心化金融(DeFi)借貸協議TrueFi和穩定幣TUSD的運營商TrustToken在新一輪融資中籌集了1250萬美元。Blocktower Capital、Andreessen Horowitz(a16z)和Alameda Research通過購買TrueFi的原生代幣TRU領投了這輪融資。TrustToken表示將利用所得款項擴大其團隊和TrueFi的運營。[2021/8/5 1:35:22]

我們再從下圖論文的原理來理解一下。圖中有一條虛線,虛線的上方是預訓練的過程。左邊的 Text Encoder,就是之前提到的文字轉換器 Transformer,它把一段文字轉換成計算機能理解的表達。右邊的 Image Encoder,也就是視覺轉換器 Vision Transformer,把人類理解的視覺圖片轉換成計算機的數據結構。

在經過大量的訓練之后,這兩者之間產生了具有相關性的連接,也就是文字和圖片之間的關系產生了非常強的理解。

虛線之下是生成的過程,把文本放進 PRIOR 模型里面,從這段文本中生成計算機能理解的視覺表達結構,再用 GLIDE 模型生成人類能看懂的圖片。雖然上下兩只小狗的圖片看起來不一樣,但它們本質上包含了同樣的文本語義,這樣就實現了任何一段文本都能生成出一張人類能看懂的圖片。

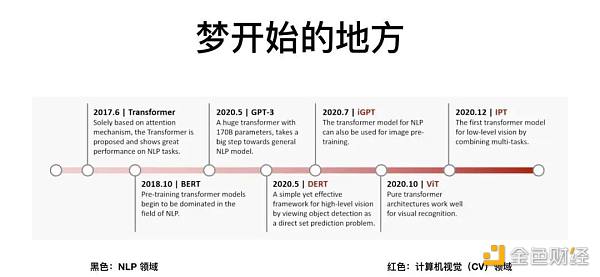

整個夢開始的地方,始于 2017 年 Google 發布的一篇論文《Attention is all you need》。它讓算法學會了人類的注意力機制,就是當我們去看一張圖片時,會看到重點,同時忽略背景的信息。

這篇論文發表之后,帶來一個 NLP 的模型,叫 Transformer,一經發布便快速屠榜,接著很快有了 BERT 模型,有了 OpenAI 的 GPT-3 模型。在視覺領域,有 DERT 模型,iGPT 模型,以及上面提到的 Vision Transformer。

Transformer 模型的重要性在于,它是我們剛才提到的三個模型的底座,學會找出圖片和文字的重點,才能夠搭建CLIP 模型,才可能有之上的 PRIOR 和 GLIDE 擴散模型。

夢想的實現還有另一半,圖像生成。

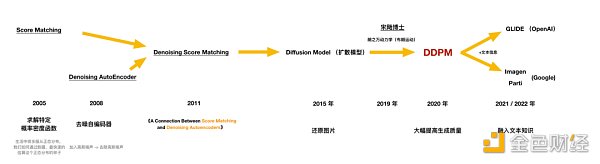

從 2005 年開始的求解特定概率密度函數,通俗理解就是通過最快的方法去估算正態分布,再到 2008 年的去噪自編碼器的研發,加入高斯噪聲,一種正態分布的噪聲,再將它去除,我們用到的很多拍照中的去噪、降噪功能就是從這里來的。到了 2011 年,有人嘗試將這兩種算法結合在一起,2015 年,開始嘗試用這種思想還原照片。但這時候還原照片的質量還不是很高。

時間撥轉到 2019 年,中國的宋飏博士把朗之萬動力學引入到數據分布的估算中,產生了非常好的效果。2020 年,Google 發布名叫 DDPM 的論文,這篇論文核心就是結合朗之萬動力學和擴散模型,產生了非常高的圖片生成質量。

2014 年引起軒然大波的 GAN network 對抗生成網絡,已經能生成出效果不錯的圖片,但它的訓練難度很高,擴散模型降低了圖像生成模型的訓練難度,還能生成比 GAN 更多元的圖像。

在夢想實現的 2021 和 2022 年,OpenAI 和 Google 都開始嘗試把文本信息加入到擴散生成的過程中,產生了今天的 GLIDE 模型。OpenAI 在思想上的突破,用 Transformer 去海量地理解圖片和文本,產生了 CLIP 模型,再用擴散模型在圖像生成中融入海量的圖文信息,優質的 AIGC 圖片終于誕生。

接下來,我們將圍繞一些問題進行討論。

1、從產品化、商業化的角度出發思考,目前 AIGC 的技術層面的發展會產生影響?

有兩個維度。第一個維度是在海量數據中尋找我們最想要的內容,第二個維度是在海量數據中得出新的內容,反向給予我們創造的靈感。

從 AI 本身的能力再進行泛化的話,一方面很多現有產品的使用體驗能得到巨大的提升,例如在筆記類的軟件中加入 AI 后,在寫作過程中能得到更好的體驗;另一方面,未來創意不強,生成能力較弱的人可能會被 AI 替代。

2、回到基本邏輯,我想確認下自己的理解是否正確:相較于 Transformer,ChatGPT 并不是在 AI 領域出現了一個顛覆性的技術創新,而只是在一個模式上加了人類的 feedback,設置了不斷迭代的參數,它自己越搞越聰明了。

過去的所有模型的進化,其實圍繞兩個方向在進化。第一個是 DNA,第二個是方法論。DNA 很像真實世界中材料的研發,方法論更像是真實世界中材料的使用。

Transformer 是 DNA 的進化,是更核心的突破。ChatGPT 是方法論,但它就更簡單了嗎?并不是的,它在探索的過程中經歷了很長的時間,同時要滿足很多先決條件,這個方法論才能得以運用。不論方法論突破還是 DNA 突破,都很有意義。

3、未來的生意模式會怎么樣?會不會更集中?圍繞這樣 ChatGPT 的模型,它會產生哪些創業方向?

可能有兩種商業模式,一種是 To B 的,就跟阿里云一樣,另外一種就是讓開發者在這種大模型上去 To C。不論是 DNA 還是在方法論上的突破,它都可能讓一個企業產生壟斷,產生巨頭效應。

ChatGPT 和用戶不斷互動,會得到源源不斷的反饋數據,數據也是一種資產,一種生產要素。這種生產要素產生的產品會是人類更高頻使用的東西,它的頻率越高,這種生產要素就越來越重要,反饋能夠創造的要素提升就越來越重要,同時帶來的經濟價值就越來越大。

4、會不會有規模效應或雙邊網絡效應?

我覺得背后既有這種網絡效應,又有一些規模效應。如果設想一下,第一個研發出來的這種中文大模型,它會快速地獲取市場上有限量的開發者,開發者在用它的產品去面向 To C 去獲取 C 端用戶,它的數據會源源不斷反饋回來,去優化它的效果,其實就會產生更強的壟斷效應。

5、從投資的角度,在 AIGC,我們應該投什么樣的團隊?

我覺得傳奇的團隊是有創造 DNA 能力的團隊,黃金的團隊是有能力把應用層和 AI 完美結合的能力,白銀的團隊就是打造 AI 領域的基礎設施的團隊。

最后分享一些我常用的工具,它們對于做投資判斷來說很有重要性,希望可以對你有所幫助 。

論文追蹤:

https://paperswithcode.com

工程模型追蹤:

https://huggingface.co/

AI 項目追蹤:

https://theresanaiforthat.com

來源:元宇宙之心

元宇宙之心

企業專欄

閱讀更多

金色財經

金色早8點

Odaily星球日報

澎湃新聞

Arcane Labs

深潮TechFlow

歐科云鏈

鏈得得

MarsBit

BTCStudy

Tags:ANSFORRANFORMOCEANS價格BeforeCoinMarketCapTrans PepeDplatform Token

作為Gambit和GMX最早的用戶之一,PANews作者經歷了GMX從默默無聞到被大家熟知的過程,但迄今為止,市場上仍然存在對GMX的大量誤解.

1900/1/1 0:00:00軟件開發和架構設計之間有著深厚的聯系,這可以從兩者所使用的詞匯中看出,例如:基礎設施、模塊、框架等.

1900/1/1 0:00:00如果把熊市比作是一場行業信心保衛戰,那么luna和三箭的崩盤可視一次滑鐵盧,更為慘烈的FTX破產究竟是不是被攻破的最后一道防線,投資者們只能暗自祈禱.

1900/1/1 0:00:00元宇宙是互聯網上的虛擬空間,用戶可以在這里操作自己的“分身”(網絡虛擬形象)與他人互動或參與活動.

1900/1/1 0:00:00在“第三屆元宇宙教育前沿峰會”上,元宇宙教育實驗室學術委員會主任、著名經濟學家、橫琴數鏈數字金融研究院學術與技術委員會主席朱嘉明以《科技狂飆突進時代和教育元宇宙——基于2022年的實證性觀察和思.

1900/1/1 0:00:00前FTX的head of trade,即刻@octopuuus ,在播客中提到一個我感興趣的視角是做市商機構視角,“莊家操盤往事lol”.

1900/1/1 0:00:00