BTC/HKD-0.09%

BTC/HKD-0.09% ETH/HKD+0.03%

ETH/HKD+0.03% LTC/HKD+1.5%

LTC/HKD+1.5% ADA/HKD+0.19%

ADA/HKD+0.19% SOL/HKD-0.7%

SOL/HKD-0.7% XRP/HKD-0.31%

XRP/HKD-0.31%▲聯邦學習問題回顧前文提及,于2016年,Google提出了用于訓練輸入法模型的新型方式,稱為「聯邦學習」。隨著時間的推移,聯邦學習不再是單純解決Google輸入法模型的一種解決方案,進而形成了一種新型的學習模式。聯邦學習解決的問題通常被稱為TMMPP--TrainingMachineLearningModelsovermultipledatasourceswithPrivacy,即在保證多方參與者的數據不泄露的情況下,共同完成預定模型的訓練。在聯邦學習解決的TMMPP問題中,包含了n個數據方{D1,D2,...Dn},其中,每個數據方對應擁有著n個數據{P1,P2,...Pn}。從聯邦學習的訓練模式來看,在選定好需要進行訓練的聯邦學習算法后,需為聯邦學習提供相應的輸入,最終得到訓練后的輸出。

聯邦學習的輸入:每個數據方將Pi其擁有的原始數據Di作為聯合建模的輸入,輸入進聯邦學習的進程中。

聯邦學習的輸出:聯合所有參與方的數據,聯邦訓練出全局模型M。

▲聯邦學習所遇挑戰

聯邦學習技術還在持續的完善中。在發展的過程中,聯邦學習會遇到三大挑戰,他們分別分別是統計挑戰、效率挑戰、安全挑戰。

統計挑戰是在聯邦學習執行過程中,因為不同用戶數據的分布或者數據量的差異造成的挑戰;

a)非獨立同分布數據,即不同用戶數據分布不獨立,有明顯的分布差別,比如甲方擁有的是中國北方的水稻種植數據,而乙方擁有的是中國南方水稻種植數據,由于緯度,氣候,人文等影響,雙方的數據是不服從于同分布的;

b)非平衡數據,即用戶的數據量有明顯的差異,比如巨頭企業掌握著近千萬的數據量,而小公司僅掌握數萬條的數據,兩者合作,小公司的數據對巨頭企業的影響微乎其微,也難以在模型訓練中做出貢獻。

效率挑戰指的是在聯邦學習中各個節點本地計算與通信的消耗造成的挑戰;

a)通信開銷,即用戶節點之間的通信,通常指的是在限定帶寬的前提下,各個用戶之間傳輸的數據量的大小,數據量越大,則通信損耗越高;

b)計算復雜度,即基于底層加密協議的計算復雜度,通常指底層加密協議計算的時間復雜度,算法計算邏輯越復雜,消耗時間越多。

安全挑戰指的是,在聯邦學習過程中,不同的用戶使用不同的攻擊手段造成信息破解、下等挑戰;

a)半誠實模型,即各用戶誠實的執行聯邦學習中的所有協議,但是會利用獲取信息嘗試分析并回推他人數據;

b)惡意模型,即存在客戶不會嚴格遵守節點之間的協議,并可能對原始數據或者中間數據進行下以破壞聯邦學習進程。

面對以上三大挑戰,學術界進行針對性的研究,提出了許多有效的、專用的聯邦學習框架來優化聯邦學習訓練過程。下文我們將對這些框架進行簡單介紹。

聯邦學習1.0–傳統聯邦學習

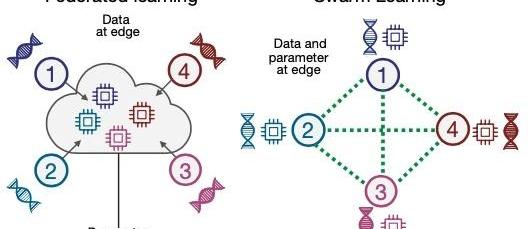

首先,我們重新闡述一下聯邦學習的概念與原理:存在若干參與方與協作方共同執行聯邦學習任務,參與方通過預置好的聯邦學習算法,生成類似于梯度的中間數據,交由協調方進行進一步的處理,隨后返還給各參與方,為下一輪的訓練做準備。

周而復始,聯邦學習任務完成。整個任務中,參與方的本地數據在各個FL框架中并沒有參與交換,但協調方和參與方之間傳輸的參數(比如梯度)可能會泄漏敏感信息。

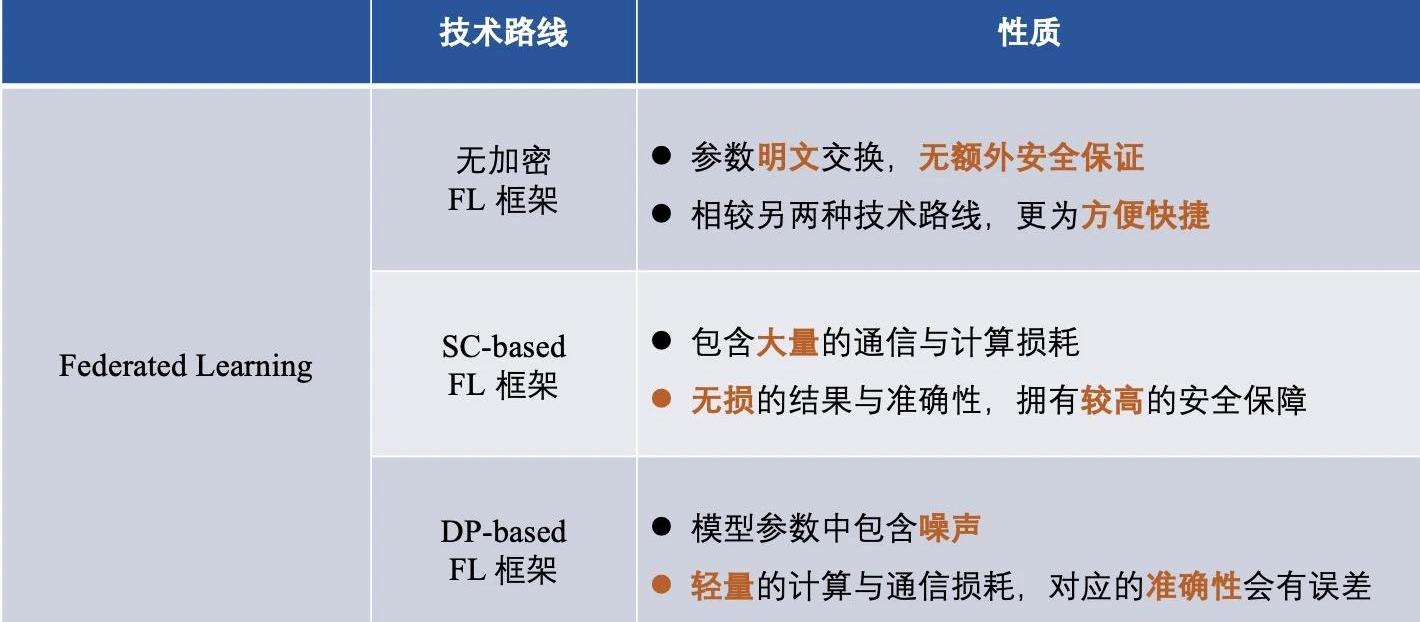

為了保護數據擁有方的本地數據不被泄露,并在訓練過程中保護中間數據的隱私,在FL的框架中應用了一些隱私技術,在參與方與協調方交互時私下交換參數。進一步,從FL框架中使用的隱私保護機制來看,將FL框架分為:

1)非加密的聯邦學習框架;

2)基于差分隱私的聯邦學習框架;

3)基于安全多方計算的的聯邦學習框架;

▲非加密的聯邦學習框架

許多FL框架側重于提高效率或解決統計異質性的挑戰,而忽略了交換明文參數所帶來的潛在風險。

路透調查:美聯儲聯邦基金利率將高于此前預期:9月28日消息,路透調查顯示,超過70%的分析師預計美聯儲將在11月連續第四次加息75個基點,在12月加息50個基點,年底時利率達到4.25%-4.50%,比兩周前預測的3.50%-3.75%高出75個基點。這將是美聯儲自金融危機開始之前的最高利率。此外,有45位經濟學家預計聯邦基金利率將在2023年第一季度達到4.50%-4.75%或更高的峰值。在回答額外問題的51位經濟學家中,除兩人外,所有人都表示,終端利率傾向于高于他們目前的預期。只有46%的經濟學家預計美聯儲在2023年底將至少降息一次。超過80%的經濟學家認為,一旦聯邦基金利率達到峰值,美聯儲更有可能在較長時間內維持利率不變,而不是迅速降息。(金十)[2022/9/28 5:57:12]

2015年,由Nishio等人提出的用于機器學習的移動邊緣計算框架FedCS,在異構數據屬主的設置的基礎上,可以快速并高效地執行FL。

2017年,由Smith等人提出了一個名為MOCHA的系統感知優化框架,該框架將FL與多任務學習相結合,通過多任務學習的方式來處理統計挑戰中的非同分布數據與數據量差異導致的各種挑戰。

同年,梁等人提出了LG-FEDAVG結合局部表示學習。他們表明,局部模型可以更好地處理異構數據,并有效地學習公平的表示,混淆受保護的屬性。

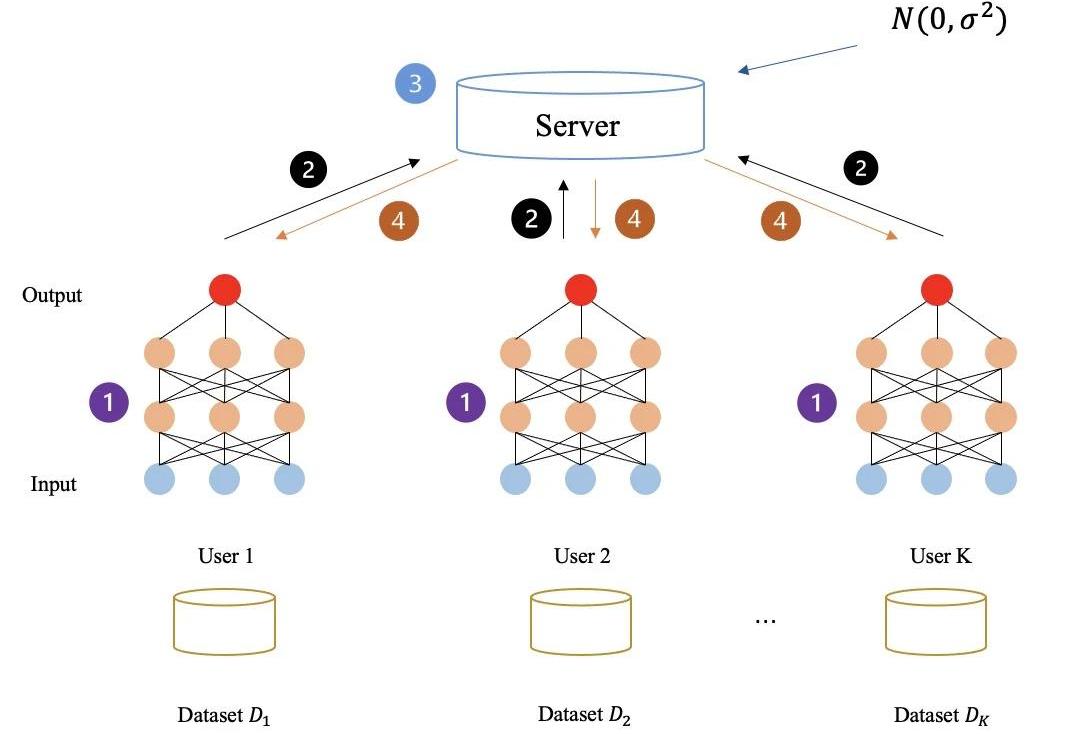

下圖所示:完全未加密任何中間數據的聯邦學習流程,所有的中間數據全是明文傳輸與計算。通過以上方式,參與方最終共同學習,得到聯邦學習模型。

▲基于差分隱私的聯邦學習框架

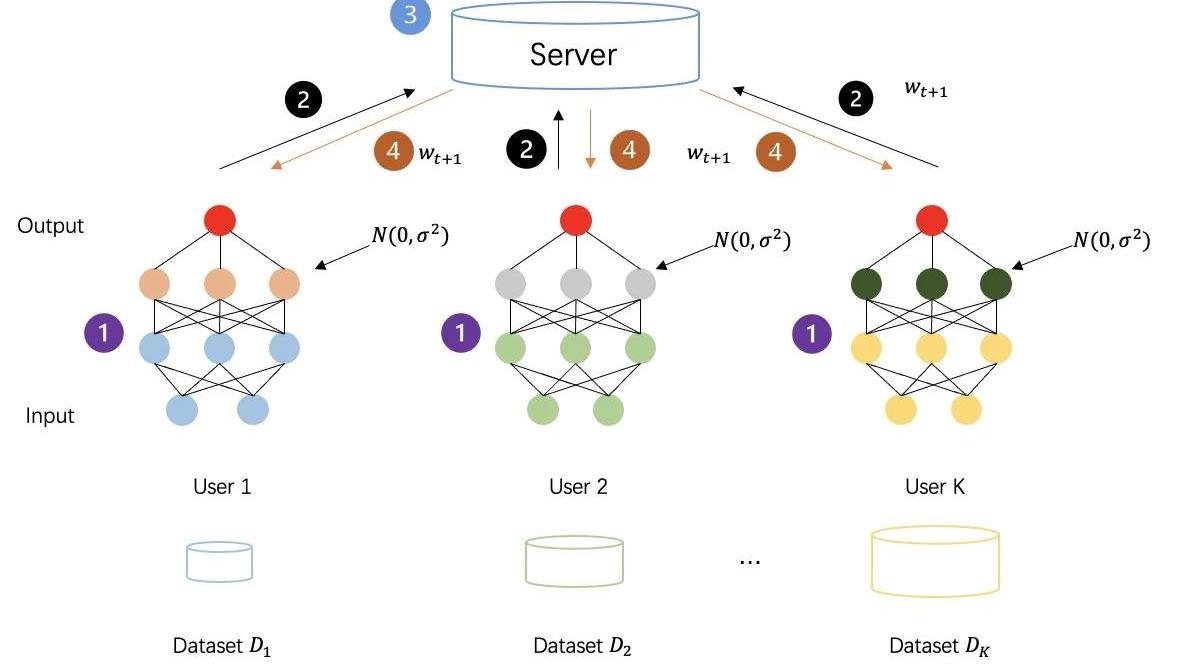

差分隱私是一種隱私技術,具有很強的信息理論保證,可以在數據中增加噪聲。滿足DP的數據集可以抵抗對私有數據的任何分析,換句話說,所獲得的數據敵手對于在同一數據集中推測其他數據幾乎是無用的。通過在原始數據或模型參數中添加隨機噪聲,DP為單個記錄提供統計隱私保證,從而使數據無法恢復以保護數據屬主的隱私。

下圖所示:采取差分隱私對中間數據進行加密后的聯邦學習流程,各方生成的中間數據不再是明文傳輸計算,而是添加過噪聲的隱私數據,以此來進一步增強訓練過程的安全性。

▲基于安全多方計算的聯邦學習框架

在FL框架中,同態加密和安全多方計算等方法得到了廣泛的應用,但它們只向參與方與協調方揭示了計算結果,過程中并沒有透露任何除計算結果外的額外的信息。

實際上,HE應用于FL框架的方式與應用于安全多方學習框架的方式類似,只是細節上略有不同。在FL框架中,HE用于保護參與方和協調方之間交互的模型參數的隱私,而不是像MPL框架中應用的HE那樣直接保護參與方之間交互的數據。在FL模型中應用加法同態來保護梯度的隱私,以提供針對半誠信中心化協調方的安全性。

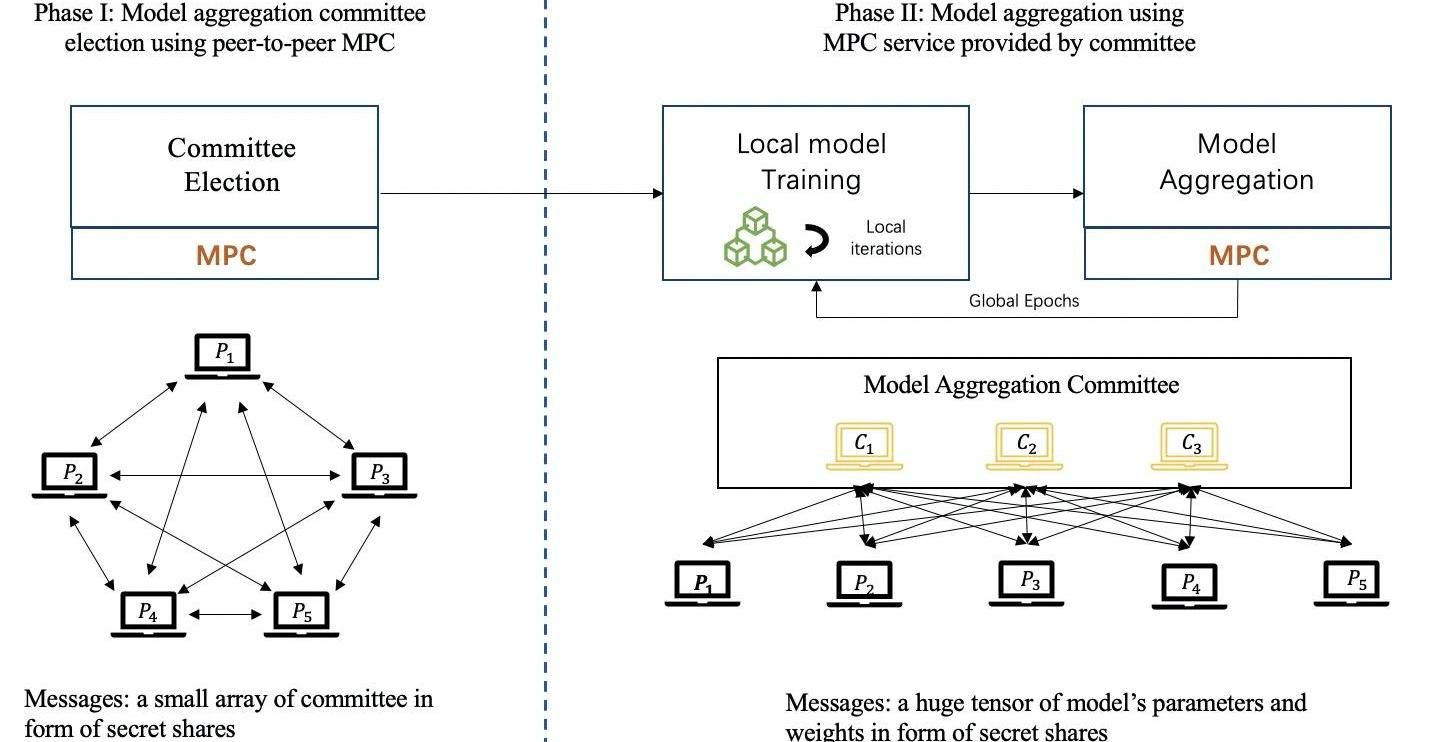

MPC涉及多個方面,并保留了原有的準確性,具有很高的安全性保證。MPC保證了每一方除了結果之外什么都不知道。因此MPC可以應用于FL模型中,用于安全聚合并保護本地模型。在基于MPC的FL框架中,集中式的協調方不能獲得任何本地信息和本地更新,而是在每一輪協作獲得聚合結果。然而,如果在FL框架中應用MPC技術將會產生大量額外的通信和計算成本。

迄今為止,秘密共享是在FL框架中應用最廣泛的MPC基礎協議,特別是Shamir的SS。

下圖所示:基于MPC的聯邦學習訓練流程,會由參與方公平的選舉出一組委員會成員作為協調方,通過執行MPC技術來協作完成模型聚合的任務。

Euterpe CEO論文被美國聯邦第二巡回法院引用:據官方消息,Euterpe CEO Jerry Liu博士的論文“An Empirical Study of Transformative Use in Copyright Law”被美國聯邦第二巡回法院在劃時代的合理使用判例Warhol vs. Goldsmith中引用,作為理論依據認定安迪·沃霍爾的名作,侵犯了平民攝影家的作品。安迪·沃霍爾為美國享譽盛名的當代藝術家,該案由其藝術基金會發起不侵權之訴,被廣泛認為是近年來文化版權領域中最具有影響力的案件之一。[2021/11/24 7:07:58]

介紹完三種FL框架后,我們總結不同技術路線的框架區別,大體如下:

聯邦學習2.0--安全多方學習

上文我們提到到「安全多方學習」,這是基于聯邦學習衍生出的一個術語,簡單來說就是:沒有第三方協作方的聯邦學習,被稱之為安全多方學習,與先前所介紹的FL區分開來。換言之,在聯邦學習的基礎上,安全多方學習剔除了傳統聯邦學習模式中的協調方,并弱化了協調方的能力,將原本的星形網絡替換成點對點網絡并使得所有參與方的地位相同。

MPL的框架大體分為四類,包括:

1)基于同態加密的MPL框架;

2)基于混淆電路的MPL框架;

3)基于秘密共享的MPL框架;

4)基于混合協議的MPL框架;

簡單來說,不同的MPL框架即為:使用了不同的密碼學協議來保障中間數據安全的框架。MPL的流程與FL大體類似,我們一起看一下使用過的四種密碼學協議:

▲同態加密

同態加密是一種加密形式,我們可以在不解密,不知道密鑰的前提下,直接對密文執行特定的代數操作。然后,它生成一個加密結果,其解密結果與在明文上執行的相同操作的結果完全相同。

HE可以分為「三種類型」:1)部分同態加密(PHE),PHE只允許無限次的一種操作;2)-3)有限同態加密與全同態加密,為了在密文中同時進行加法和乘法SWHE和FHE。SWHE可以在有限次數內執行某些類型的操作,而FHE可以在無限次數處理所有操作。FHE的計算復雜度比SWHE和PHE要昂貴得多。

▲混淆電路

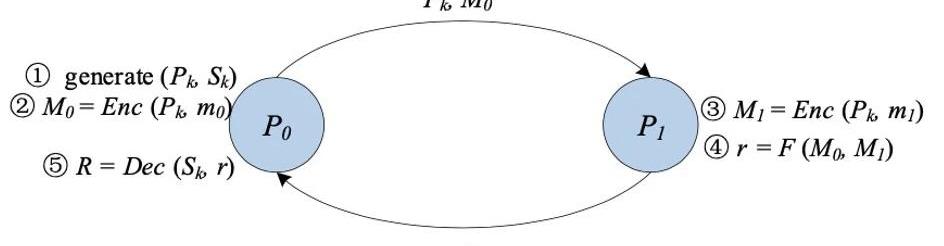

混淆電路,又稱姚氏混淆電路,是由姚期智院士提出的一種安全的兩方計算的底層技術。GC提供了一個交互式協議,讓兩方(一個混淆者garbler和一個評估者evaluator)對一個任意函數進行無意識的評估,這個函數通常表示為一個布爾電路。

在經典GC的構造中主要包括三個階段:加密、傳輸、評估。

首先,對于電路中的每一條線,混淆者生成兩個隨機字符串作為標簽,分別代表該線可能的兩個位值“0”和“1”。對于電路中的每一個門,混淆者都會創建一個真值表。真值表的每個輸出都是用與其輸入相對應的兩個標簽進行加密。這是由混淆者選擇一個密鑰推導函數,利用這兩個標簽生成對稱密鑰。

然后,混淆者對真值表的行進行換行。在混淆階段結束后,混淆者將混淆后的表以及與其輸入為對應的輸入線標簽傳送給評估者。

此外,評估者通過不經意傳輸安全地獲取其輸入對應的標簽。有了混淆表和輸入線的標簽,評估者負責對混淆表進行反復解密,直至得到函數的最終結果。

▲秘密共享

GMW協議是第一個安全的多方計算協議,允許任意數量的一方安全地計算一個可以表示為布爾電路或算術電路的函數。以布爾電路為例,所有各方使用基于XOR的SS方案共享輸入,各方交互計算結果,逐門計算。基于GMW的協議不需要對真值表進行混淆,只需要進行XOR和AND運算進行計算,所以不需要進行對稱的加解密操作。此外,基于GMW的協議允許預先計算所有的加密操作,但在在線階段需要多方進行多輪交互。因此,GMW在低延遲網絡中取得了良好的性能。

聲音 | 克利夫蘭聯邦儲備銀行行長:比特幣不是一種實用的支付方式:克利夫蘭聯邦儲備銀行行長Loretta Mester表示,比特幣不是一種實用的付款方式,因為它無法促進更快的支付。Loretta Mester稱,比特幣的價值是不穩定的,受貨幣投機的驅動,使其作為一個記賬單位的用處不大。它的結算時間太慢,無法用于主流支付。此外,她還指出,比特幣的操作成本要比法定貨幣高。盡管比特幣的市值已增長至1860億美元以上,但由于其分散的性質,使得其更難以解決可能出現的任何爭端,或隨著平臺的發展可能需要進行的技術更改。(AMBCrypto)[2020/2/16]

BGW協議是3方以上的算術電路安全多方計算的協議。該協議的總體結構與GMW類似。一般來說,BGW可以用來計算任何算術電路。與GMW協議類似,對于電路中的加法門,計算是可以在本地進行的,而對于乘法門,各方需要交互。但是,GMW和BGW在交互形式上有所不同。BGW不是使用OT來進行各方之間的通信,而是依靠線性SS來支持乘法運算。但BGW依靠的是誠實多數制(honest-majority)。BGW協議可以對抗除t<n/2個腐壞方的半誠實敵手,對抗t<n/3個腐壞方的惡意敵手。

SPDZ是Damgard等人提出的一種不誠實多數制計算協議,它能夠支持兩方以上的計算算術電路。它分為離線階段和在線階段。SPDZ的優勢在于昂貴的公鑰密碼計算可以在離線階段完成,而在線階段則純粹使用廉價的、信息理論上安全的基元。SWHE用于在離線階段執行constant-round的安全乘法。SPDZ的在線階段是linear-round,遵循GMW范式,在有限域上使用秘密共享來確保安全。SPDZ最多可以對抗惡意敵手的t<=n個腐壞方,其中t為敵手數量,n為計算方數。

將集中密碼學協議進行階段性總結,不同技術路線對應的框架區別大體如下:

聯邦學習3.0--群學習

2021年,波恩大學的JoachimSchultze和他的合作伙伴提出了一種名為SwarmLearning的「去中心化機器學習系統」,這是基于MPL進一步的衍化升級,它取代了當前跨機構醫學研究中集中數據共享的方式。SwarmLearning通過Swarm網絡共享參數,再在各個參與方的本地數據上獨立構建模型,并利用區塊鏈技術對試圖破壞Swarm網絡的不誠實參與者采取強有力的措施。

相較于FL與MPL,SwarmLearning將區塊鏈的技術引入到聯邦學習的訓練過程中,很好地將區塊鏈取代了公信第三方,起到訓練協同的作用。

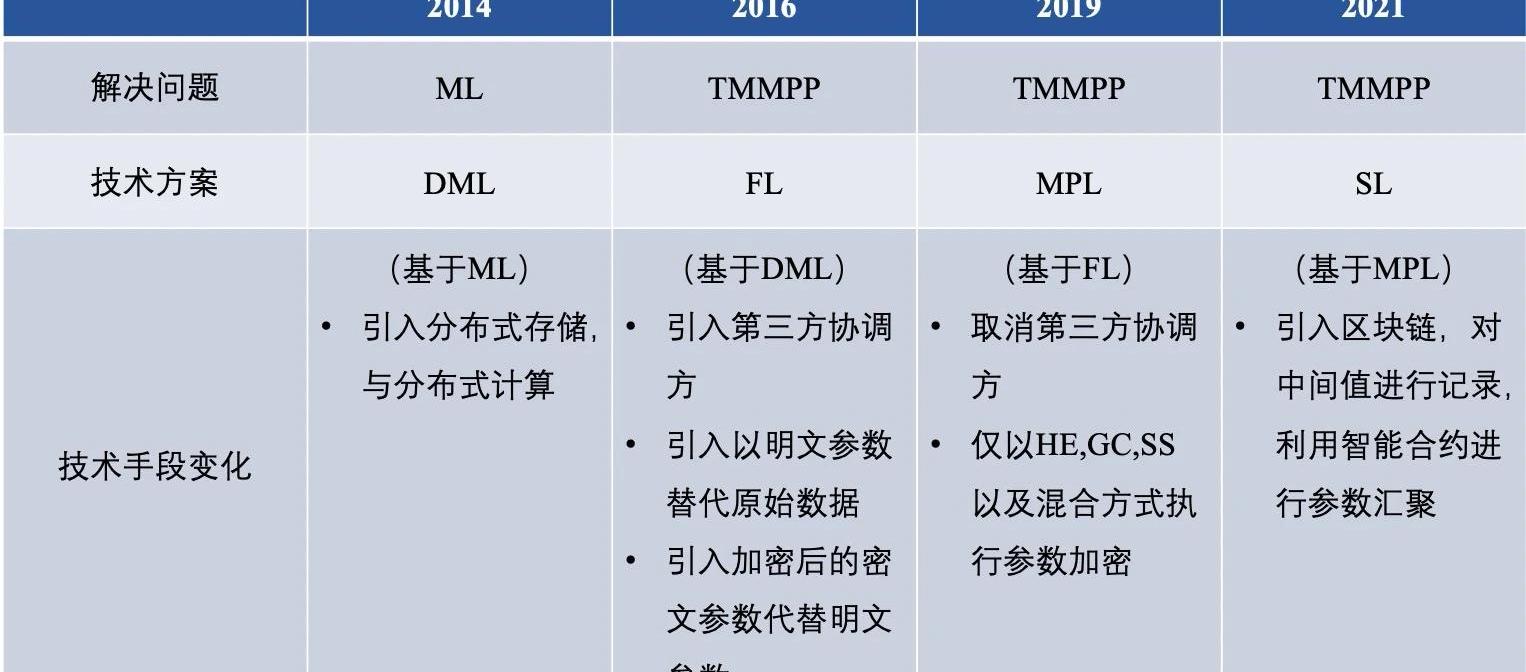

▲聯邦學習技術路線比較

縱觀聯邦學習的前世今生,其已經擁有了多種解決問題的技術路線,經總結,分布式機器學習,聯邦學習,安全多方學習,群學習的差異大體如下:

這其中,我們將傳統的FL與MPL進行更深層次的對比,體現在以下六點:

1)隱私保護

MPC框架中使用的MPC協議為雙方提供了很高的安全性保證。然而,非加密FL框架在數據屬主和服務器之間交換模型參數是明文的,敏感信息也可能被泄露;

2)通信方式

在MPL中,數據屬主之間的通信通常是在沒有可信第三方的情況下以對等的形式進行的,而FL通常是以具有集中式服務器的Client-Server的形式進行的。換句話說,MPL中的每個數據屬主在狀態上是相等的,而FL中的數據屬主和集中式服務器是不對等的;

聲音 | 懷俄明州眾議院代表:應在聯邦一級澄清加密貨幣稅收問題:懷俄明州眾議院代表Tyler Lindholm在談及加密技術時表示,隨著有關法律的討論越來越多,許多現有的法律將最終被廢除,因為它們不適合今天的公民的需要。“應該發生的最重要的事情是,在美國聯邦一級澄清稅收問題。我們已經在懷俄明州做了我們所能做的一切,即對加密時段不征收州級稅。”(AMBCrypto)[2019/9/30]

3)通信開銷

對于FL,由于數據屬主之間的通信可以由一個中心化服務器來協調,通信開銷比MPL的點對點形式更小,特別是當數據屬主的數量非常大時;

4)數據格式

目前,在MPL的解決方案中,不考慮非IID設置。然而,在FL的解決方案中,由于每個數據屬主都在本地訓練模型,因此更容易適應非IID設置;

5)訓練模型的準確性

在MPL中,在全局模型中通常沒有精度損失。但如果FL利用DP保護隱私,全局模型通常會有一定的準確性損失;

6)應用場景

結合上述分析,可以發現MPL更適合于安全性和準確性較高的場景,而FL更適合于性能要求較高的場景,用于更多的數據擁有方。

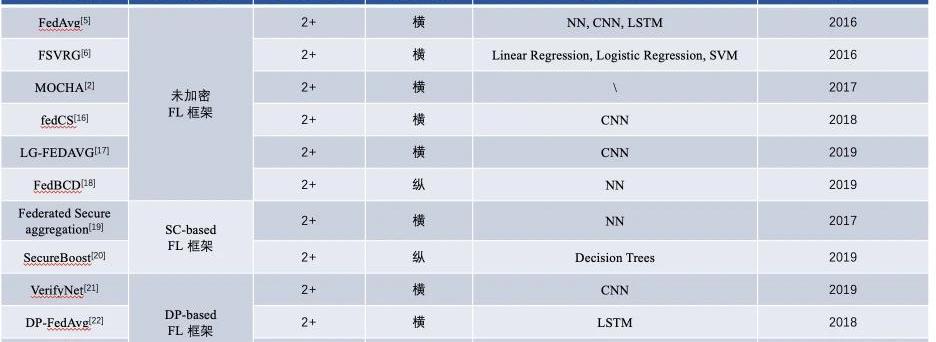

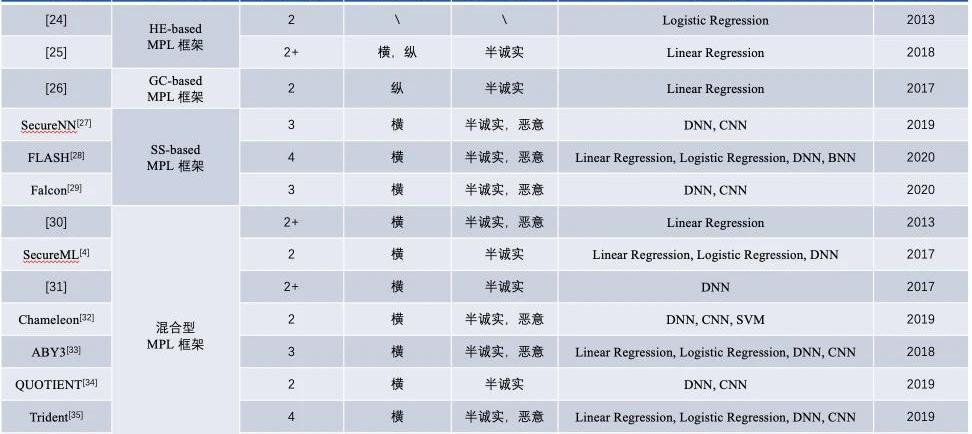

▲聯邦學習框架多方比較

自2016年FL基礎性框架的內容對比

基于FL的MPL基礎框架的內容對比

隨著聯邦學習技術的不斷發展,針對不同挑戰的聯邦學習平臺不斷涌現,但仍未達到成熟的階段。目前,在學術界中,聯邦學習平臺主要解決的問題是非平衡與非同分布的數據問題,而工業界更多的把眼光放在了密碼學協議上來解決聯邦學習的安全問題。

兩邊齊頭并進,將現有的很多機器學習算法實現了聯邦化,但仍不成熟,并未達到可以落地投產的階段。近幾年,聯邦學習框架的研究與落地仍處于初級階段,需要持續不斷的努力和推進。

作者簡介

嚴楊聯邦學習后驅者

趣鏈科技數據網格實驗室BitXMesh團隊

參考文獻

P.VoigtandA.VondemBussche,“Theeugeneraldataprotectionregulation(gdpr),”APracticalGuide,1stEd.,Cham:SpringerInter-nationalPublishing,2017.

D.Bogdanov,S.Laur,andJ.Willemson,“Sharemind:Aframeworkforfastprivacy-preservingcomputations,”inProceedingsofEuropeanSymposiumonResearchinComputerSecurity.Springer,2008,pp.192–206.

D.Demmler,T.Schneider,andM.Zohner,“Aby-aframeworkforefficientmixed-protocolsecuretwo-partycomputation.”inProceedingsofTheNetworkandDistributedSystemSecuritySymposium,2015.

P.MohasselandY.Zhang,“Secureml:Asystemforscalableprivacy-preservingmachinelearning,”inProceedingsof2017IEEESymposiumonSecurityandPrivacy(SP).IEEE,2017,pp.19–38.

動態 | 瑞士聯邦數據保護和信息專員希望得到Libra項目詳細信息:據路透社消息,瑞士隱私辦公室在周二的一份聲明中表示,瑞士聯邦數據保護和信息專員(FDPIC)注意到大衛·馬庫斯先生在美國參議院委員會聽證會上的發言,但并沒有沒有收到任何有關可能處理哪些個人數據的指示,Libra協會應將該項目的當前狀態詳細信息通知他,以便他能夠評估自己的咨詢能力和監督權力將在多大程度上得到應用。馬庫斯本月早些時候在參議院聽證會上說,他預計FDPIC專員將成為Libra的隱私監管機構,因為Libra協會的總部設在日內瓦。[2019/7/24]

H.B.McMahan,E.Moore,D.Ramage,andB.A.yArcas,“Feder-atedlearningofdeepnetworksusingmodelaveraging,”CoRR,vol.abs/1602.05629,2016.

J.Konecˇny`,H.B.McMahan,D.Ramage,andP.Richta?rik,“Federatedoptimization:Distributedmachinelearningforon-deviceintelligence,”arXivpreprintarXiv:1610.02527,2016.

J.Konecˇny`,H.B.McMahan,F.X.Yu,P.Richta?rik,A.T.Suresh,andD.Bacon,“Federatedlearning:Strategiesforimprovingcommunica-tionefficiency,”arXivpreprintarXiv:1610.05492,2016.

B.McMahan,E.Moore,D.Ramage,S.Hampson,andB.A.yArcas,“Communication-efficientlearningofdeepnetworksfromdecentral-izeddata,”inProceedingsofArtificialIntelligenceandStatistics,2017,pp.1273–1282.

A.C.-C.Yao,“Howtogenerateandexchangesecrets,”inProceedingsofthe27thAnnualSymposiumonFoundationsofComputerScience(sfcs1986).IEEE,1986,pp.162–167.

V.Smith,C.-K.Chiang,M.Sanjabi,andA.S.Talwalkar,“Federatedmulti-tasklearning,”inProceedingsofAdvancesinNeuralInformationProcessingSystems,2017,pp.4424–4434.

R.Fakoor,F.Ladhak,A.Nazi,andM.Huber,“Usingdeeplearningtoenhancecancerdiagnosisandclassification,”inProceedingsoftheinternationalconferenceonmachinelearning,vol.28.ACMNewYork,USA,2013.

M.Rastegari,V.Ordonez,J.Redmon,andA.Farhadi,“Xnor-net:Imagenetclassificationusingbinaryconvolutionalneuralnetworks,”inProceedingsofEuropeanconferenceoncomputervision.Springer,2016,pp.525–542.

F.Schroff,D.Kalenichenko,andJ.Philbin,“Facenet:Aunifiedembeddingforfacerecognitionandclustering,”inProceedingsoftheIEEEconferenceoncomputervisionandpatternrecognition,2015,pp.815–823.

P.VoigtandA.VondemBussche,“Theeugeneraldataprotectionregulation(gdpr),”APracticalGuide,1stEd.,Cham:SpringerInter-nationalPublishing,2017.

D.Bogdanov,S.Laur,andJ.Willemson,“Sharemind:Aframeworkforfastprivacy-preservingcomputations,”inProceedingsofEuropeanSymposiumonResearchinComputerSecurity.Springer,2008,pp.192–206.

T.NishioandR.Yonetani,“Clientselectionforfederatedlearningwithheterogeneousresourcesinmobileedge,”inProceedingsof2019IEEEInternationalConferenceonCommunications(ICC).IEEE,2019,pp.1–7.

P.P.Liang,T.Liu,L.Ziyin,R.Salakhutdinov,andL.-P.Morency,“Thinklocally,actglobally:Federatedlearningwithlocalandglobalrepresentations,”arXivpreprintarXiv:2001.01523,2020.

Y.Liu,Y.Kang,X.Zhang,L.Li,Y.Cheng,T.Chen,M.Hong,andQ.Yang,“Acommunicationefficientverticalfederatedlearningframework,”arXivpreprintarXiv:1912.11187,2019.

K.Bonawitz,V.Ivanov,B.Kreuter,A.Marcedone,H.B.McMahan,S.Patel,D.Ramage,A.Segal,andK.Seth,“Practicalsecureaggre-gationforprivacy-preservingmachinelearning,”inProceedingsofthe2017ACMSIGSACConferenceonComputerandCommunicationsSecurity,2017,pp.1175–1191.

K.Cheng,T.Fan,Y.Jin,Y.Liu,T.Chen,andQ.Yang,“Se-cureboost:Alosslessfederatedlearningframework,”arXivpreprintarXiv:1901.08755,2019.

G.Xu,H.Li,S.Liu,K.Yang,andX.Lin,“Verifynet:Secureandverifiablefederatedlearning,”IEEETransactionsonInformationForensicsandSecurity,vol.15,pp.911–926,2019.

H.B.McMahan,D.Ramage,K.Talwar,andL.Zhang,“Learn-ingdifferentiallyprivaterecurrentlanguagemodels,”arXivpreprintarXiv:1710.06963,2017.

Y.Zhao,J.Zhao,M.Yang,T.Wang,N.Wang,L.Lyu,D.Niyato,andK.Y.Lam,“Localdifferentialprivacybasedfederatedlearningforinternetofthings,”arXivpreprintarXiv:2004.08856,2020.

M.Hastings,B.Hemenway,D.Noble,andS.Zdancewic,“Sok:Generalpurposecompilersforsecuremulti-partycomputation,”inProceedingsof2019IEEESymposiumonSecurityandPrivacy(SP).IEEE,2019,pp.1220–1237.

I.Giacomelli,S.Jha,M.Joye,C.D.Page,andK.Yoon,“Privacy-

preservingridgeregressionwithonlylinearly-homomorphicencryp-tion,”inProceedingsof2018InternationalConferenceonAppliedCryptographyandNetworkSecurity.Springer,2018,pp.243–261.

A.Gasco?n,P.Schoppmann,B.Balle,M.Raykova,J.Doerner,S.Zahur,andD.Evans,“Privacy-preservingdistributedlinearregressiononhigh-dimensionaldata,”ProceedingsonPrivacyEnhancingTechnologies,vol.2017,no.4,pp.345–364,2017.

S.Wagh,D.Gupta,andN.Chandran,“Securenn:3-partysecurecomputationforneuralnetworktraining,”ProceedingsonPrivacyEnhancingTechnologies,vol.2019,no.3,pp.26–49,2019.

M.Byali,H.Chaudhari,A.Patra,andA.Suresh,“Flash:fastandrobustframeworkforprivacy-preservingmachinelearning,”ProceedingsonPrivacyEnhancingTechnologies,vol.2020,no.2,pp.459–480,2020.

S.Wagh,S.Tople,F.Benhamouda,E.Kushilevitz,P.Mittal,andT.Rabin,“Falcon:Honest-majoritymaliciouslysecureframeworkforprivatedeeplearning,”arXivpreprintarXiv:2004.02229,2020.

V.Nikolaenko,U.Weinsberg,S.Ioannidis,M.Joye,D.Boneh,andN.Taft,“Privacy-preservingridgeregressiononhundredsofmillionsofrecords,”pp.334–348,2013.

M.Chase,R.Gilad-Bachrach,K.Laine,K.E.Lauter,andP.Rindal,“Privatecollaborativeneuralnetworklearning.”IACRCryptol.ePrintArch.,vol.2017,p.762,2017.

M.S.Riazi,C.Weinert,O.Tkachenko,E.M.Songhori,T.Schneider,andF.Koushanfar,“Chameleon:Ahybridsecurecomputationframe-workformachinelearningapplications,”inProceedingsofthe2018onAsiaConferenceonComputerandCommunicationsSecurity,2018,pp.707–721.

P.MohasselandP.Rindal,“Aby3:Amixedprotocolframeworkformachinelearning,”inProceedingsofthe2018ACMSIGSACConferenceonComputerandCommunicationsSecurity,2018,pp.35–52.

N.Agrawal,A.ShahinShamsabadi,M.J.Kusner,andA.Gasco?n,“Quotient:two-partysecureneuralnetworktrainingandprediction,”inProceedingsofthe2019ACMSIGSACConferenceonComputerandCommunicationsSecurity,2019,pp.1231–1247.

R.RachuriandA.Suresh,“Trident:Efficient4pcframeworkforpri-vacypreservingmachinelearning,”arXivpreprintarXiv:1912.02631,2019.

A.PatraandA.Suresh,“Blaze:Blazingfastprivacy-preservingma-chinelearning,”arXivpreprintarXiv:2005.09042,2020.

SongL,WuH,RuanW,etal.SoK:Trainingmachinelearningmodelsovermultiplesourceswithprivacypreservation.arXivpreprintarXiv:2012.03386,2020.

前言 北京時間11月7日,知道創宇區塊鏈安全實驗室監測到跨鏈協議SynapseProtocol推出的資產跨鏈橋被攻擊,攻擊者設法降低了nUSDMetapool虛擬價格并從中獲利約800萬美元.

1900/1/1 0:00:00近日Filecoin官方發布博客,將推出Filecoin虛擬機,為Filecoin網絡引入智能合約的可編程性.

1900/1/1 0:00:0010月25日,zCloakNetwork項目創始人張曉參加了由Web3基金會和萬象區塊鏈主辦的2021Web3.0BootcampDemoDay.

1900/1/1 0:00:009月17日,BlockBenCMOZoltanVeszer做客嗶嗶大咖秀,暢談BlockBen如何利用區塊鏈技術將傳統金融市場和加密貨幣世界連接起來。以下是嗶嗶News整理的AMA實錄.

1900/1/1 0:00:00Polkadot生態研究院出品,必屬精品波卡一周觀察,是我們針對波卡整個生態在上一周所發生的事情的一個梳理,同時也會以白話的形式分享一些我們對這些事件的觀察.

1900/1/1 0:00:00美國機構發布了一份關于穩定幣的報告,指出了消費者應注意的潛在風險,并提出了相應的建議。這些機構的工作人員咨詢了主要的市場參與者、貿易協會成員、專家和倡導者.

1900/1/1 0:00:00